Team:SupBiotech-Paris/Introduction1Fr

From 2009.igem.org

Enguerrand (Talk | contribs) (→Le Double Vector System) |

Enguerrand (Talk | contribs) (→Le Double Vector System) |

||

| Line 155: | Line 155: | ||

'''Le mécanisme d’action du DVS :'''<br> | '''Le mécanisme d’action du DVS :'''<br> | ||

| - | [[Image:Mecanisme. | + | [[Image:Mecanisme.mov|center]] |

Revision as of 22:12, 20 October 2009

Contents |

Le concept de vectorisation

Principe de vectorisation [1]

L’adressage de molécules thérapeutiques vers un organe, un tissu ou une cellule malade constitue aujourd’hui un défi majeur. Dès le début du siècle, le savant Paul Ehrlich rêvait déjà de « magic bullet » susceptible d’acheminer un principe actif de manière spécifique vers son site d’action. Le rêve de Paul Ehrlich est aujourd’hui proche de la réalité grâce au développement de la vectorisation pharmaceutique.

De nombreux principes actifs présentent, en effet, des caractéristiques physico-chimiques (hydrophilie, poids moléculaires etc...) peu favorables au passage des barrières biologiques qui séparent le site d’administration du site d’action. D'autres molécules actives se heurtent aussi à des barrières enzymatiques entraînant leur dégradation et métabolisation rapides.

D'une manière générale, il faut noter que les barrières à traverser sont des systèmes très complexes faisant intervenir plusieurs éléments (épithélium, endothélium, membrane cellulaire) et plusieurs composantes (barrières mécaniques et physico-chimiques et barrières enzymatiques). L’obtention de concentrations thérapeutiques au niveau du site d’action ne peut donc se faire qu’au détriment d’une importante déperdition de médicament vers d’autres tissus ou cellules ce qui entraîne des effets toxiques importants et parfois rédhibitoires.

D’autre part, le développement des biotechnologies a donné accès à des protéines recombinantes et à des gènes clonés, en grande quantité. Parallèlement, les progrès de la chimie organique sur support permettent la création d’oligopeptides et d’oligonucléotides. Ces molécules sont, sans doute, à la base des médicaments de demain : très sélectifs au niveau moléculaire, ils conduisent à des métabolites endogènes, c’est-à-dire non toxiques. Cependant, les caractéristiques physicochimiques et biomimétiques de ces molécules les rendent très difficiles à administrer. Elles sont, en effet, toujours mal absorbées (au niveau cellulaire et tissulaire) et souvent très rapidement dégradées et métabolisées et incapables d’atteindre leur cible au niveau tissulaire ou cellulaire. C'est l'une des principales limites au développement de ces molécules comme médicaments.

C’est pour toutes ces raisons que le développement de vecteurs de principes actifs a pris un essor considérable au cours des dernières années. S’appuyant sur de nouveaux concepts physico-chimiques, la recherche galénique a permis d’imaginer des systèmes submicroniques d’administration, biologique ou chimique, capables : (i) de protéger la molécule active de la dégradation et (ii) d’en contrôler la libération dans le temps et dans l’espace.

Modification de la pharmacocinétique, de la pharmacodynamique et de la biodisponibilité [1,2]

Un médicament « classique » est distribué dans l’organisme en fonction de ses propriétés physico-chimiques :

- pKa,

- Lipophilie,

- Kd (fixation aux protéines).

En revanche, un médicament « vectorisé » est distribué dans l’organisme en fonction des propriétés de son vecteur :

- Taille du vecteur,

- Lipophilie du vecteur,

- Charge globale du vecteur,

- Stabilité du vecteur,

- Immunogénicité du vecteur.

Sa distribution, donc sa biodisponibilité n’est plus la même. Or la biodisponibilité agit directement sur l’efficacité et la toxicité d’un principe actif. Si l’on concentre la dose injectée en un endroit, on obtient une meilleure efficacité que si l’on dilue cette dose dans un organisme entier.

Ainsi, un médicament vectorisé, n’étant pas distribué de la même manière n’a pas la même efficacité ni la même toxicité qu’un médicament « classique ».

Dans le cas d’un médicament « vectorisé », on s’affranchie de la distribution naturelle du médicament. On permet le ciblage du principe actif sur sa cible, et la concentration de la dose sur la surface d’intérêt. On augmente ainsi l’efficacité tout en diminuant la toxicité.

Les composants d’un vecteur [3,4]

Un vecteur est un nanotransporteur composé de plusieurs éléments.

Il y a tout d’abord le réservoir, c'est-à-dire l’élément de stockage du principe actif. Cet élément peut être très divers en fonction de la nature du vecteur. Il peut, par exemple, être composé de phospholipides comme dans le cas des liposomes, ou encore de protéines, comme dans le cas des virus. Mais de quelque nature qu’il soit, le réservoir à pour fonction le stockage et la protection du principe actif.

Ensuite, il y a le système d’adressage, ce système permet de changer complètement la biodisponibilité du vecteur et de libérer préférentiellement le principe actif dans un organe, un tissu ou encore une cellule souhaitée. Ce système est souvent fait de petites molécules ou de protéines reconnues par un ligand membranaire exposé à la surface de la cellule cible.

Enfin, un dernier élément, le système de « furtivité ». Pourquoi et par rapport à qui ?

Un vecteur, faisant généralement plus de 60nm et pouvant être chargé, est détecté par le système immunitaire. C’est l’une des principales problématiques de cette technologie. C’est pourquoi des systèmes de « furtivité » ont été élaborés.

Tous les vecteurs n’ont pas les mêmes composants, ni les mêmes possibilités. Chaque type de vecteur a donc des caractéristiques propres.

Les types de vecteurs [5,6,7,8,9,10,11,12]

Il existe deux grandes classes de vecteurs, les vecteurs biologiques et les vecteurs chimiques.

Un premier type de vecteurs biologiques, les vecteurs viraux. Les vecteurs viraux sont des particules virales véhiculant un génome artificiellement modifié, au regard de celui de la souche virale dont le vecteur est dérivé.

Les virus représentent les vecteurs naturels les plus évolués pour le transfert d’une information génétique étrangère dans une cellule. De nombreux virus ont donc fait l’objet d’adaptation en vecteurs : les plus avancés sont les rétrovirus, les adénovirus et les virus adéno-associés (AAV).

Le cycle viral naturel se divise en deux phases distinctes : infection et réplication. L’infection consiste en l’introduction du génome viral dans la cellule. L’expression des gènes viraux aboutit dans un second temps à la formation de nouvelles particules virales, c’est la réplication.

Au cours de la production de virus recombinants, les particules virales encapsident un génome modifié contenant la cassette d’expression du gène d’intérêt thérapeutique à la place de tout ou partie du génome viral.

La transduction se définit alors comme une infection abortive par le virus recombinant défectif, pour la réplication, qui introduit seulement une information génétique fonctionnelle dans la cellule cible.

L’avantage de ce type de vecteur est qu’il est naturellement un vecteur d’information génétique, il a ainsi toute capacité à voyager dans le torrent circulatoire, à reconnaître un marqueur cible et à pénétrer la cellule d’intérêt pour y intégrer le gène thérapeutique. Mais il possède également des inconvénients : sa forte immunogénicité, la possibilité de recombinaison du génome viral in vivo et son industrialisation.

Autre type de vecteur viral, bactérien cette fois-ci, les phages. Ces virus particuliers ont d’autres caractéristiques que les virus eucaryotes. Ils fonctionnent de la même manière, ce sont également des vecteurs naturels d’information génétique. En revanche, originaire du monde procaryote, ils sont beaucoup plus sûrs à utiliser, plus simples à produire, mais aussi beaucoup moins efficaces face à un environnement eucaryote. Leur génome doit intégrer des séquences spécifiques leur permettant d’augmenter leur efficacité de transfection. Ils possèdent, tout comme les virus eucaryotes, une facilité à intégrer une information génétique d’intérêt thérapeutique au sein de leur capside et une facilité à cibler un marqueur cible. Néanmoins, ils pénètrent très mal les cellules eucaryotes et leur immunogénicité est aussi très forte.

Pour finir, les derniers vecteurs de classe biologique, les bactéries. Ce type de vecteur, des plus originaux, n’est que très peu étudié et développé uniquement en laboratoire. Principalement utilisé pour la sécrétion de protéine In Vivo, ce vecteur ne peut pas transfecter de cellule d’intérêt. Les essais pratiqués porte sur la sécrétion de facteurs d’inflammation, ou autre agent immunostimulant, au sein de tumeur. Outre son inefficacité à transduire de l’information génétique au sein de cellule d’intérêt, les vecteurs bactériens sont immunogènes et potentiellement dangereux pour l’Homme. Ce type de vecteur existe tout de même car il apporte certaines possibilités qui lui sont propres. Le vecteur bactérien peut cibler un tissu et y délivrer une protéine d’intérêt thérapeutique, il est également facile à produire et dans certains cas, selon la souche, il résiste au système immunitaire.

Dans la seconde classe de vecteurs, on retrouve les vecteurs nanoparticulaires lipidiques et polymériques.

Les vecteurs nanoparticulaires sont des systèmes colloïdaux dont la structure est généralement constituée de lipides ou de polymères, de préférence biodégradables. Les nanoparticules peuvent être de type matriciel; dans ce cas, le principe actif peut être dispersé ou dissous dans la matrice et être libéré par simple diffusion ou à la suite de la biodégradation dans l’organisme. Les nanoparticules peuvent aussi être de type réservoir, dans ce cas, elles sont constituées d’un noyau central généralement liquide entouré par une mince paroi de lipides ou de polymères dont l’épaisseur ne dépasse pas quelques nanomètres.

Les nanoparticules lipidiques ont l’avantage d’être biomimétique et biodégradable, en revanche elles sont peu stables, leur capacité de compaction avec l’ADN est 40 à 50 fois moins importante qu’un virus de la même taille et elles sont fortement immunogènes, même avec des molécules dites de « furtivité » (e.g. PEG).

Les nanoparticules polymériques sont plus stables que leurs homologues lipidiques, mais elles pénètrent moins bien les membranes. Elles ont une potentielle toxicité et sont tout aussi immunogène, même avec des molécules dites de « furtivité ».

Chaque type de vecteur a des propriétés qui lui sont propres, mais chaque type possède également des problématiques. La technologie de vectorisation a de nombreuses problématiques récurrentes, spécifiques ou non à un type de vecteur.

Les problématiques de la vectorisation [13,14,15,16,17,18,19]

Aujourd’hui six problématiques majeures restent non résolues :

- Stabilité,

- Toxicité,

- Ciblage/spécificité,

- Passage de la membrane,

- Système immunitaire : résistance ou furtivité,

- Industrialisation.

La stabilité est un problème ne concernant principalement que les nanoparticules lipidiques. En effet les autoassemblages lipidiques tels que les liposomes ne sont pas stables dans le temps. In Vivo, ce type de vecteur s’agrège ou se disrupte, libérant alors son contenu. Certaines molécules, comme le cholestérol, peuvent améliorer leur stabilité, mais ils restent les vecteurs les plus fragiles et donc les moins protecteurs pour le principe actif.

La toxicité est une problématique d’origine double. Elle peut être issue d’une potentialité, de certains vecteurs, à devenir incontrôlables ou elle peut être issue des méthodes de fabrication de certains autres vecteurs. Les virus sont certainement les meilleurs vecteurs, mais ils sont aussi les plus dangereux. La potentialité, même pour les virus défectifs, qu’ils se répliquent sans contrôle dans l’organisme d’un patient, est importante, cela étant dû au phénomène de recombinaison génomique, très fréquent dans ce type de particule biologique.

L’autre problème de toxicité provient des méthodes de fabrication des nanoparticules. L’utilisation de solvant organique pour leur conception est potentiellement dangereuse pour le patient, car même avec les étapes d’éliminations, la dose de solvant organique injectée n’est jamais nulle.

Le ciblage est une problématique étrange, censé être un avantage technologique apporté par la vectorisation, le ciblage est loin d’être optimal. Ce dernier s’effectue par reconnaissance d’un marqueur membranaire exprimé à la surface des cellules cibles. Le problème est justement là, une quantité très faible de marqueurs membranaires sont spécifiques à un type cellulaire dans tout l’organisme. Donc, même si la dose d’agent thérapeutique est plus forte au niveau des cellules cibles, d’autre cellules dans le corps vont subir les effets de l’agent thérapeutique.

Le passage de la membrane est un événement clé pour un médicament, l’efficacité de se dernier est lié à sa capacité à franchir cette barrière. L’agent thérapeutique, dont l’action est subcellulaire, doit pénétrer la cellule pour pouvoir agir. Les vecteurs de type procaryote ainsi que les nanoparticules polymériques sont très handicapés par cette étape cruciale dans le devenir d’un médicament.

Le système immunitaire est certainement la problématique insurmontable. Le système immunitaire est à la fois non spécifique et spécifique. De ce fait, il se fixe sur tout ce qui fait plus de 60nm et qui se trouve dans le torrent circulatoire. Il s’adapte et réagit plus vite au fur et à mesure des rencontres avec les vecteurs. On sait depuis bien longtemps que les virus, les phages et les bactéries sont détectés par le système immunitaire et éliminés. La première détection est toujours tardive par rapport à l’injection du vecteur, laissant ainsi une certaine efficacité à la première dose. Mais lors de la seconde injection, la clairance est tellement rapide que l’efficacité du vecteur est quasi nulle.

Certains s’accordent à dire que ce problème n’est pas transposable aux nanoparticules, qui bénéficient de molécules de furtivité. Ces molécules, comme par exemple le Polyéthylène Glycol (PEG) empêcheraient la reconnaissance par le système immunitaire par répulsion stérique. Mais ceci n’est pas vrai, ou du moins uniquement en mono-injection, les PEG, comme toutes autres molécules de furtivité, offre un épitope accessible aux anticorps et autres opsonines du corps. Ainsi, lors de la seconde injection, une réponse du système immunitaire s’organise et la clairance est accélérée, réduisant considérablement l’efficacité thérapeutique.

Cependant, les vecteurs reconnus par les opsonines et non dégradés sont adsorbés par les macrophages du système hépatosplénique (foie et rate), ainsi il est très facile avec cette technologie de cibler des physiopathologies du foie et de la rate. Car c’est tout naturellement, via les macrophages hépatiques et spléniques, que l’organisme va concentrer la dose de médicaments « vectorisés » au sein de ces deux organes.

L’industrialisation est une problématique d’un autre ordre. Elle reste cependant essentielle à maîtriser. Bon nombre de technologies révolutionnaire n’ont jamais abouties en raison d’une incapacité à être transposé à l’échelle industrielle. Cela peut être le cas pour certains types de vecteurs. Hormis les vecteurs de type procaryote, le coût de production d’un vecteur est très élevé à l’heure actuelle. C’est d’autant plus vrai dans le cas des vecteurs viraux qui doivent être produits par des cellules eucaryotes, ce qui semble être un frein énorme à leur commercialisation. Pour ce qui est des nanoparticules, le prix est pour l’instant élevé mais cependant certains produits, à tropisme hépatosplénique, sont tout de même sur le marché. En revanche, la fabrication de vecteurs plus complexes, nécessitant plus de composants, de nombreuses étapes de conception et l’utilisation de solvant organique a un coût de production encore très élevé.

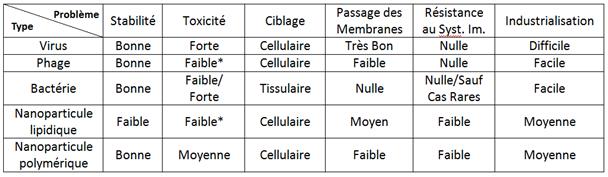

En résumé, un tableau récapitulatif de chaque type de vecteurs face aux problématiques de la vectorisation :

On observe, dans le tableau ci-dessus, que chaque type de vecteur échoue face à au moins une problématique. On peut ainsi dire que cette technologie, si prometteuse soit-elle, est face à un verrou technologique.

Ce tableau récapitulatif montre que chaque type de vecteur possède au moins un problème. Or pour chaque problématique un ou plusieurs types de vecteurs répondant positivement.

Les virus, les phages et les bactéries étant des vecteurs biologiques, on peut ainsi les associer pour former le vecteur optimal, répondant à toutes problématiques majeures.

Le Double Vector System

La biologie synthétique est basée sur le principe que tous les gènes, une fois standardisés, peuvent être assemblés pour former un algorithme biologique.

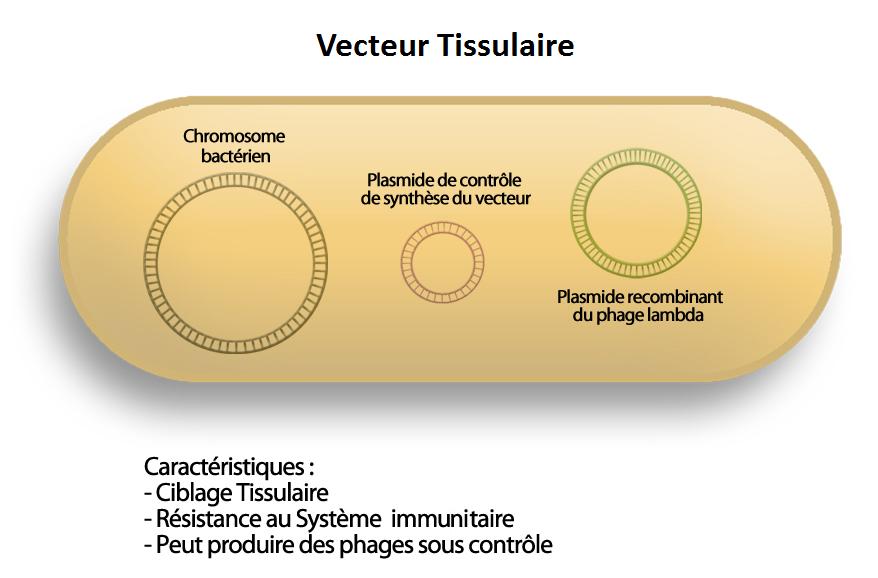

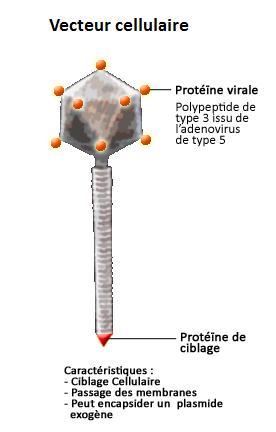

Conçu sur ce principe, le Double Vector System (DVS) se compose d’une bactérie, d’un phage et de protéines de virus eucaryote. Un mélange complexe qui offre, à la technologie de vectorisation, la clé à ses problématiques majeures.

Les composants du DVS :

et

et

Le DVS est composé d’un premier vecteur, tissulaire, de type bactérien, capable d’atteindre un tissu sans être éliminé par le système immunitaire. Et d’un second vecteur, crée par le premier, de type phagique, capable d’atteindre une cellule cible et de s’y internaliser, grâce à des protéines virales exposées à sa capside. Une fois sa cible atteinte, il libère un plasmide thérapeutique qui a une action contre la maladie.

Le mécanisme d’action du DVS :

Le DVS ne se contente pas que répondre aux problématiques sous-jacentes à la vectorisation, il améliore certaines caractéristiques intrinsèques à la technologie.

Découvrez plus en détail chaque composant du DVS au travers des autres pages du site.

"

"